实干、实践、积累、思考、创新。

在我们发布第一篇API部署DeepSeek R1 ( 本地API 召唤满血DeepSeek R1 )之后,很多热心的小伙伴和我们建议考虑使用完全本地部署DeepSeek R1,这样回答速度更快、更体现隐私性、更能检验你的电脑配置。

在正式开始之前我们先来看看你是否真的想要完全本地部署。

Step 0 思辨:我是否需要本地部署DeepSeek R1 ?

本地部署的优缺点

在开始前先和大家唠叨两句。 相较于API调用,本地部署的意思就是把DeepSeek R1(下文简称DS)模型下载到本地,再通过本地工具访问DS进行对话,这种情况下DS不会上传用户语料,包括提问、知识库、智能体等。信息安全大概是本地部署的最大好处。其余的优缺点对比请各位小伙伴看下图体会:

(大模型本地部署的优缺点)

本地部署的模型差异

目前网络公开的DS 模型有6个蒸馏版+1个完整版(俗称满血版):

蒸馏版有:1.5B, 7B, 8B, 14B, 32B, 70B;

完整版:671B。

首先版本号的B是模型参数的单位Billion(十亿);然后解释下蒸馏,蒸馏Distillation是一种模型压缩技术,其核心是通过知识迁移(Knowledge Transfer)将复杂教师模型(Teacher Model)中的函数映射能力/隐式知识,高效转移到更轻量的学生模型(Student Model)中。

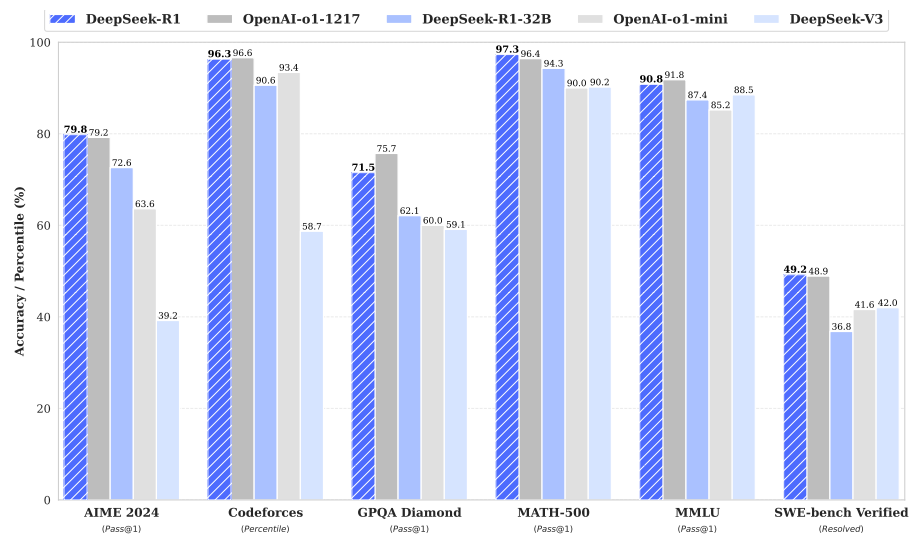

满血版和蒸馏版可以简单理解为名师和高徒的关系,名师(671B)将自身的知识传授给学生,其中比较出色的几位是高徒(1.5B, 7B, 8B, 14B, 32B, 70B),官方给出了名师和各位高徒的各科考试成绩,从Figure1和Table5可见,名师671B成绩更优异,高徒32B在各位徒弟中较为出色。

Figure 1 | Benchmark performance of DeepSeek-R1【1】

Table 5 | Comparison of DeepSeek-R1 distilled models and other comparable models on reasoning-related benchmarks【1】

本地部署的配置建议

这里结合DeepSeek回答和网络测评拉个表给大家参考,以下配置均未考虑模型量化作用,仅供粗略参考。

上面提到的32B模型作为满血版671B模型的平替,对设备的要求依然不低。

| 版本 | 模型大小 | CPU | 内存 | 硬盘 | 显卡 |

| 1.5B | 1.1 GB | 4核 | 8GB+ | 5 GB+ | 4GB+显存(如GTX 1650) |

| 7B | 4.7 GB | 8核+ | 16GB+ | 10 GB+ | 8GB+显存(如RTX 3070/4060) |

| 8B | 4.9 GB | 8核+ | 16GB+ | 10 GB+ | 8GB+显存(如RTX 3070/4060) |

| 14B | 9.0 GB | 12核+ | 32GB+ | 20 GB+ | 16GB+显存(如RTX 4090或A5000) |

| 32B | 20 GB | 16核+ | 64GB+ | 40 GB+ | 24GB+显存(如A100 40GB或双卡RTX 3090) |

| 70B | 43 GB | 32核+ | 128GB+ | 80 GB+ | 多卡并行(如2xA100 80GB或4xRTX 4090) |

| 671B | 404 GB | 64核+ | 512GB+ | 1 T + | 多节点分布式训练(如8xA100/H100) |

两句话总结:设备够强、不差钱;时间不耐;数据敏感、需信息保密可以考虑本地部署。

随便玩玩网页版和API调用足矣。

结合上述条件,经过你的深思熟虑,现在可以选择离场或继续阅读。

无论如何,请先给小编点个赞吧!

本地部署所需工具

- Ollama

- DeepSeek R1 蒸馏模型

- Cherry Studio, Anything LLM e.g.

Step1 安装Ollama

安装地址:https://ollama.com

进入Ollama 首页点击Download。

Ollama 网址首页

选择适合自己系统的程序,下载并安装。

Ollama 下载选项

![]() Ollama 安装文件

Ollama 安装文件

Ollama 程序图标

Ollama 程序图标

Ollama 安装完成后,我们可以通过cmd 输入ollama查看其操作指令; 输入ollama list 查看模型信息(下图模型还未安装);输入ollama -v可查看软件版本。感兴趣的小伙伴可以根据操作指令去尝试。

cmd 查询Ollama信息

Step2 选择蒸馏模型

在Ollama网页左上角,选择Models。

Ollama–Models

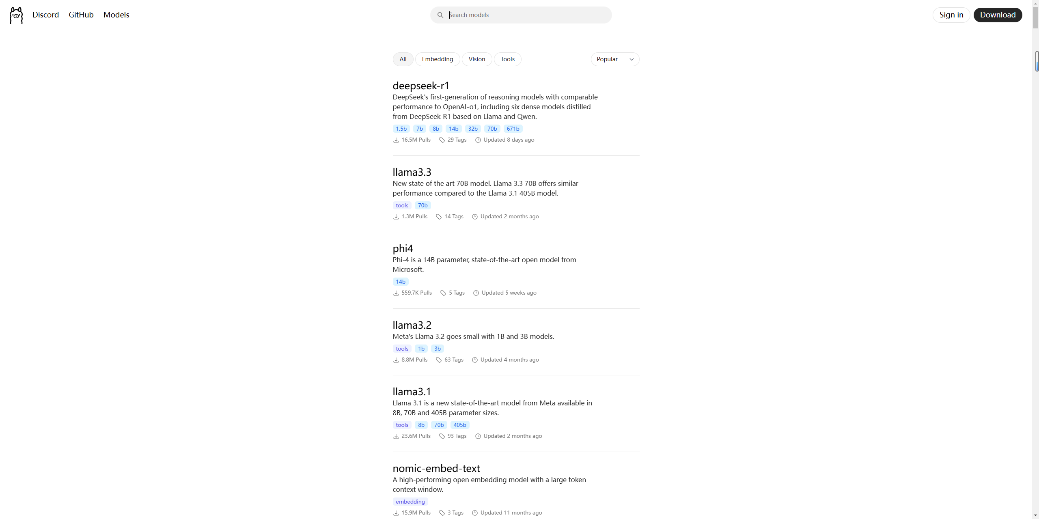

进入后选择DeepSeek R1。

Ollama–Models库

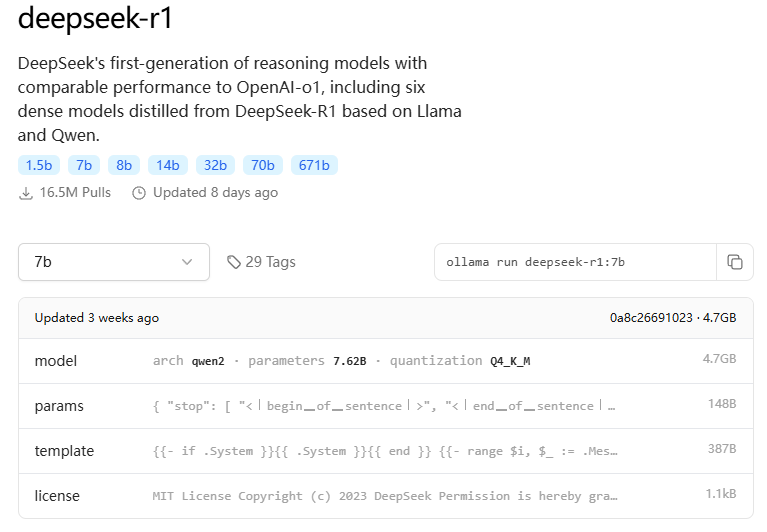

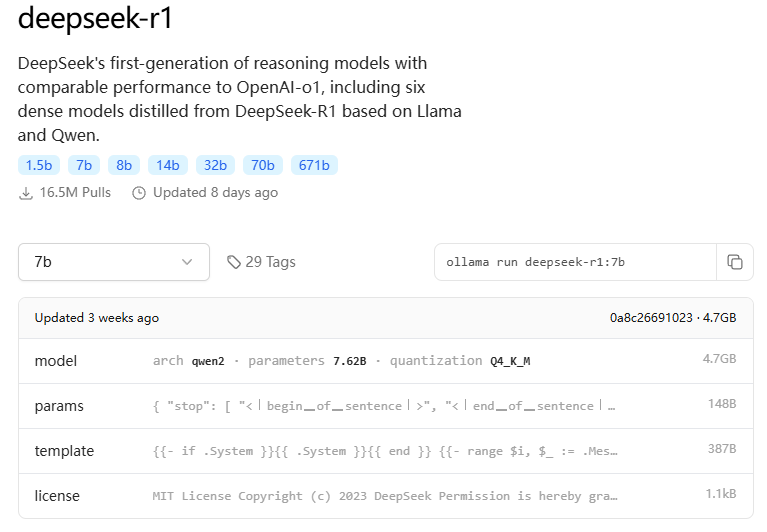

各位小伙伴可根据自己的电脑配置,选择蒸馏模型,网页会展示对应模型的相关信息,作为普通用户,我们可能最关心的只是模型的大小。这里根据我的电脑硬件配置我选7b。

Ollama DS模型信息

Step3 下载蒸馏模型

选择后将右侧的命令复制,准备在命令提示符中运行。

Ollama DS模型安装指令

下载所需模型

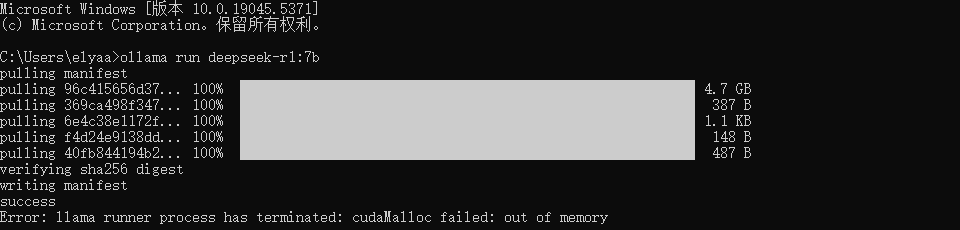

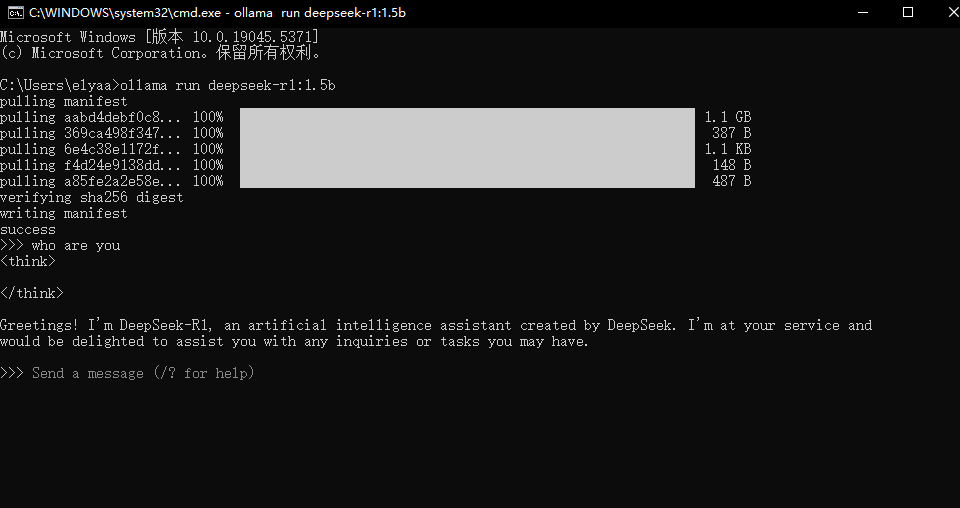

在cmd中,运行下载指令:ollama run deepseek-r1:7b。

cmd下载DS模型

显示Success即下载完成。

cmd提示 DS模型下载成功

Ollama提示下图即可对话。

cmd中与DS对话

但是都2025了,谁还喜欢和cmd对话呢?

各路厂商为大家提供了更多的对话工具选择。

Step4 用Cherry Studio调用本地模型进行对话

目前主流AI工具是Cherry Studio和Chatbox,这里以Cherry Studio作为演示,其它工具的调用方式类似。

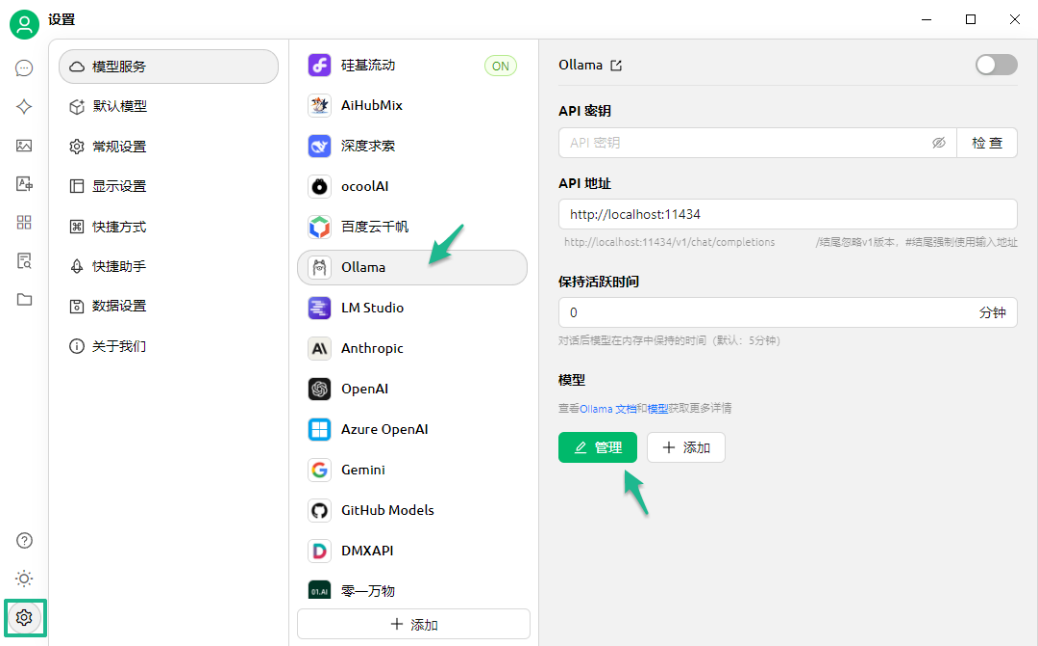

在Cherry Studio中点击左下角设置,进入模型服务,选择Ollama,此时是没有模型的,点击管理。

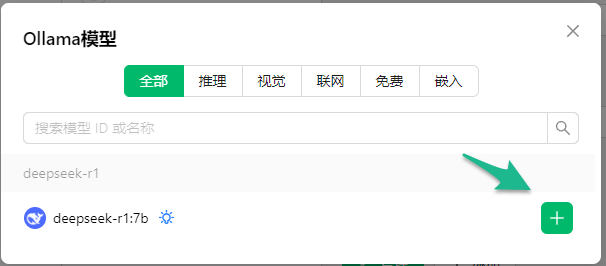

此时程序已检测到本地模型7b,点击+号。

密钥可以随意填,因为这是本地布置,不需要API,点击检查。

看到连接成功,Ollama图标为ON,调用完成,可以去对话了。

![]()

![]()

调整上方对话模型,开始愉快的本地对话吧!

参考文献

[1] DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning.本文编者介绍

关于我们

超限设计 | 软件定制开发| 环评减振控制 |人致振动控制 | 减隔震设计 | 施工过程模拟 | 小品钢结构 | 有限元开发 | BIM与参数化 | 大震弹塑性

追求卓越 脚踏实地 致力于探索和拓展行业设计前沿

https://www.jdcui.com

合作及技术咨询

COOPERATION & CONTACT

E-mail:jidong_cui@163.com

WeChat & Tel: 13450468449

![Grasshopper建筑结构参数化建模应用实例[Practical Examples of Parametric Modeling for Building Structures Using Grasshopper]](http://www.jdcui.com/wp-content/uploads/2026/01/封面.png)